A general-purpose streaming big data statistics system.

Easier to use, supports a larger amount of data, and can complete more statistical indicators faster.

通用型流式大数据统计技术开创者、布道者、引领者。

并行承载1000万个数据指标,每天处理5000亿条消息。

新一代全景式实时业务监控系统,即时掌控业务运行状态,全面提升业务驾驭能力。

除大数据版本外,同时支持单机版!

打造成本最低的数据化运营方案,帮助企业快速搭建业务指标监控体系。

概述

- XL-LightHouse是针对企业繁杂的数据统计需求而开发的一套集成了数据写入、数据运算和数据可视化等一系列功能,支持超大数据量,支持超高并发的【实时业务监控系统】。

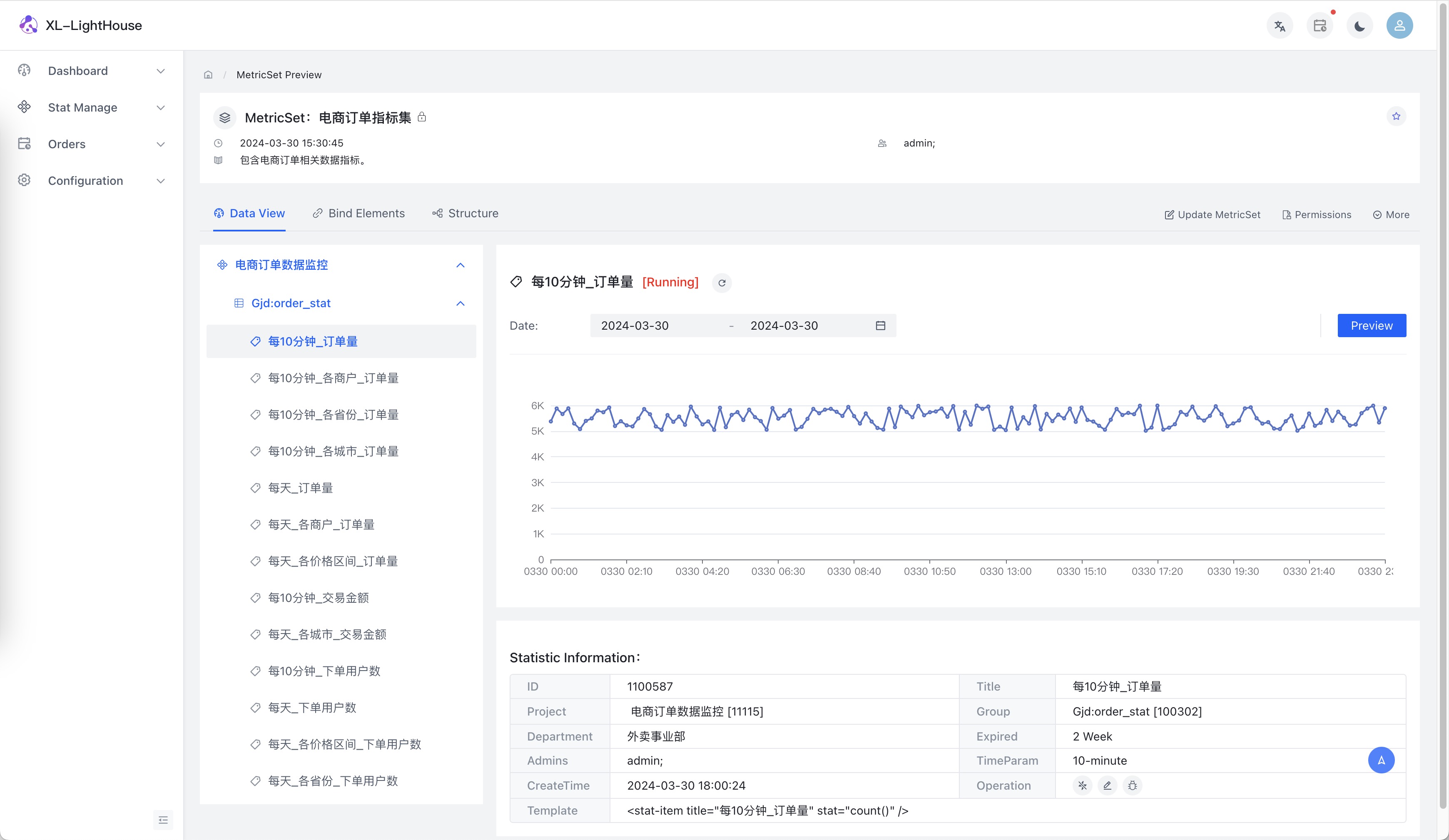

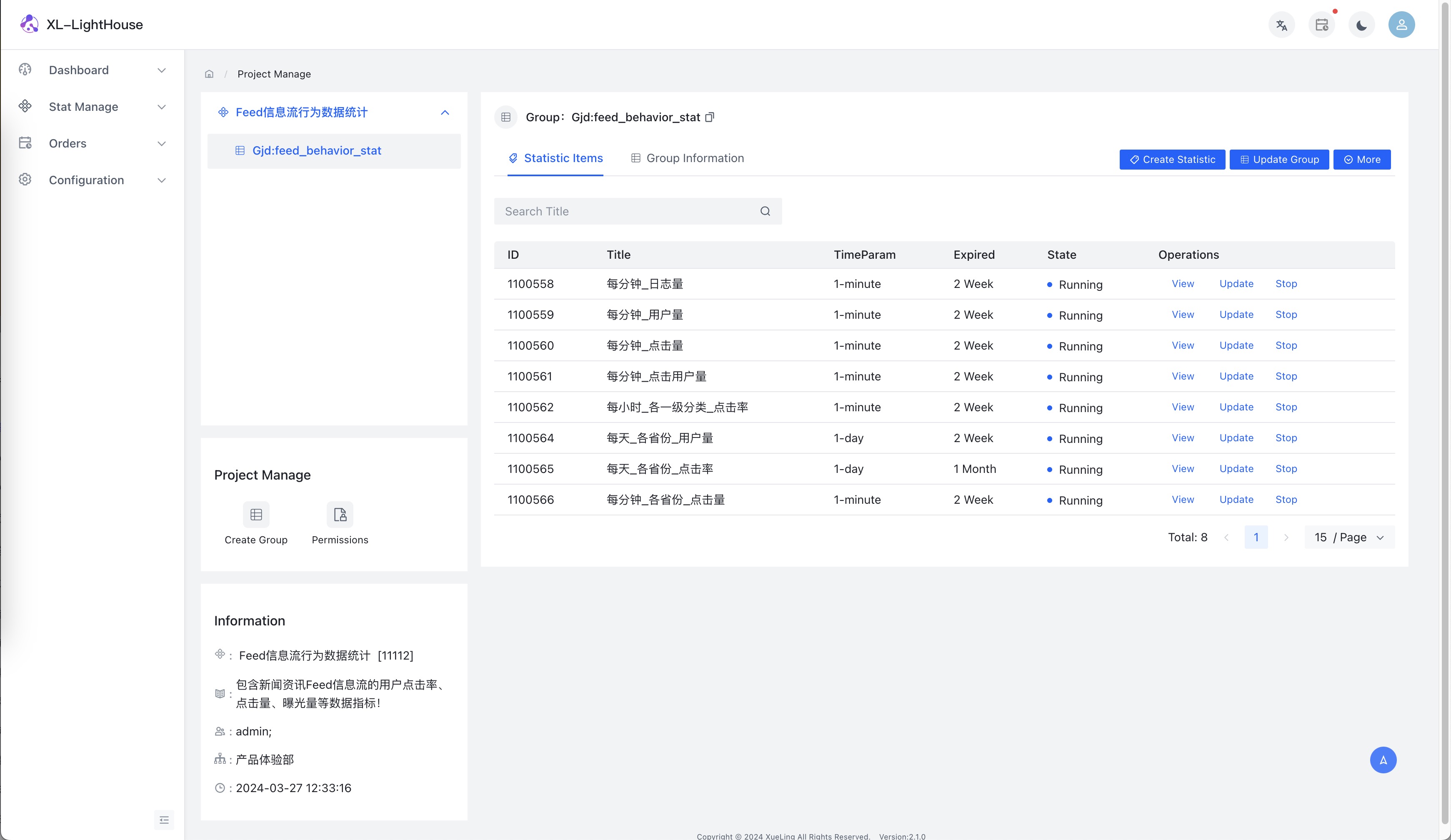

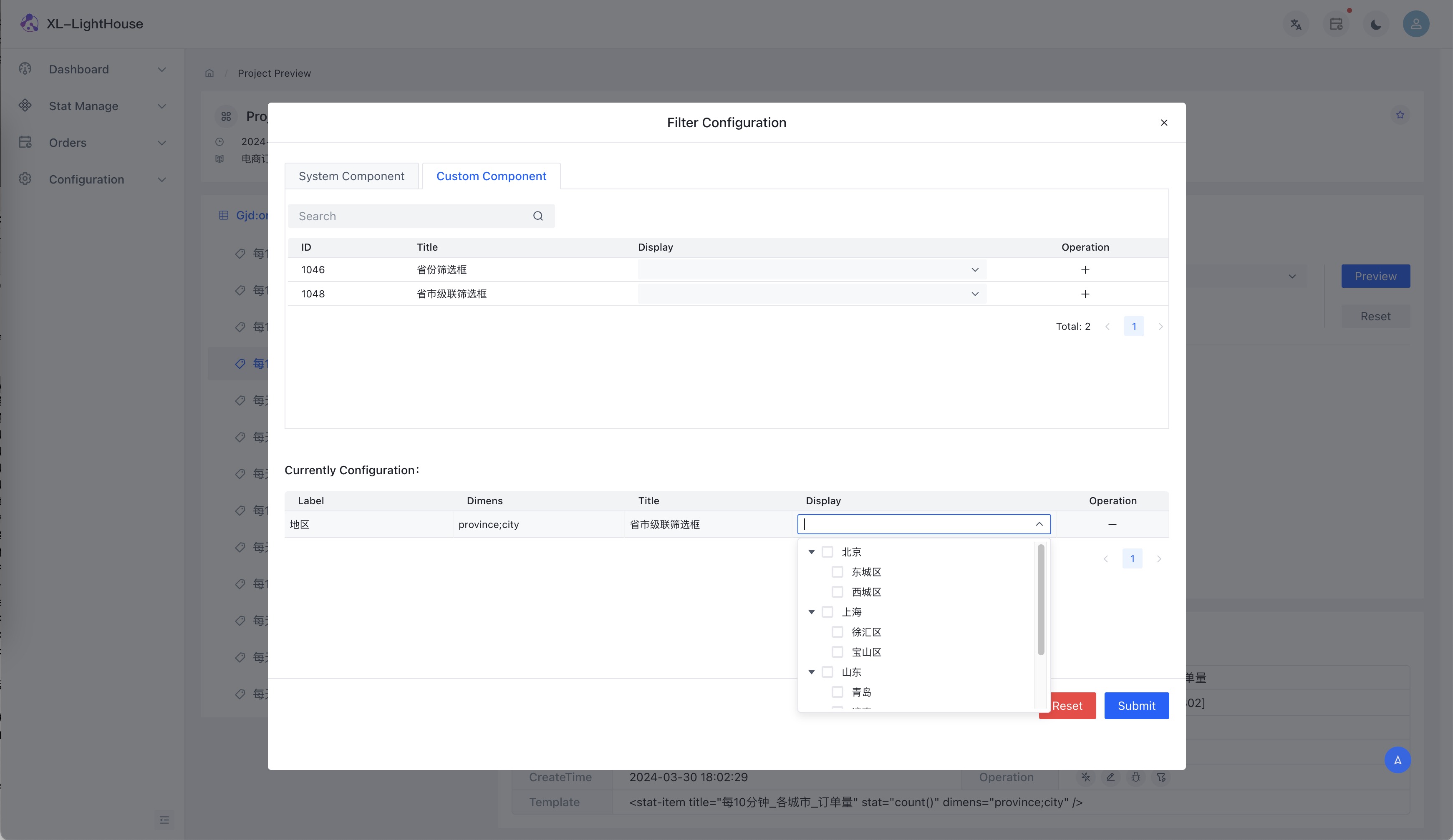

- XL-LightHouse目前已涵盖了各种流式数据统计场景,包括count、sum、max、min、avg、distinct、topN/lastN等多种运算,支持多维度计算,支持分钟级、小时级、天级多种时间粒度的统计,支持自定义统计周期的配置。

- XL-LightHouse内置丰富的转化类函数、支持表达式解析,可以满足各种复杂的条件筛选和逻辑判断。

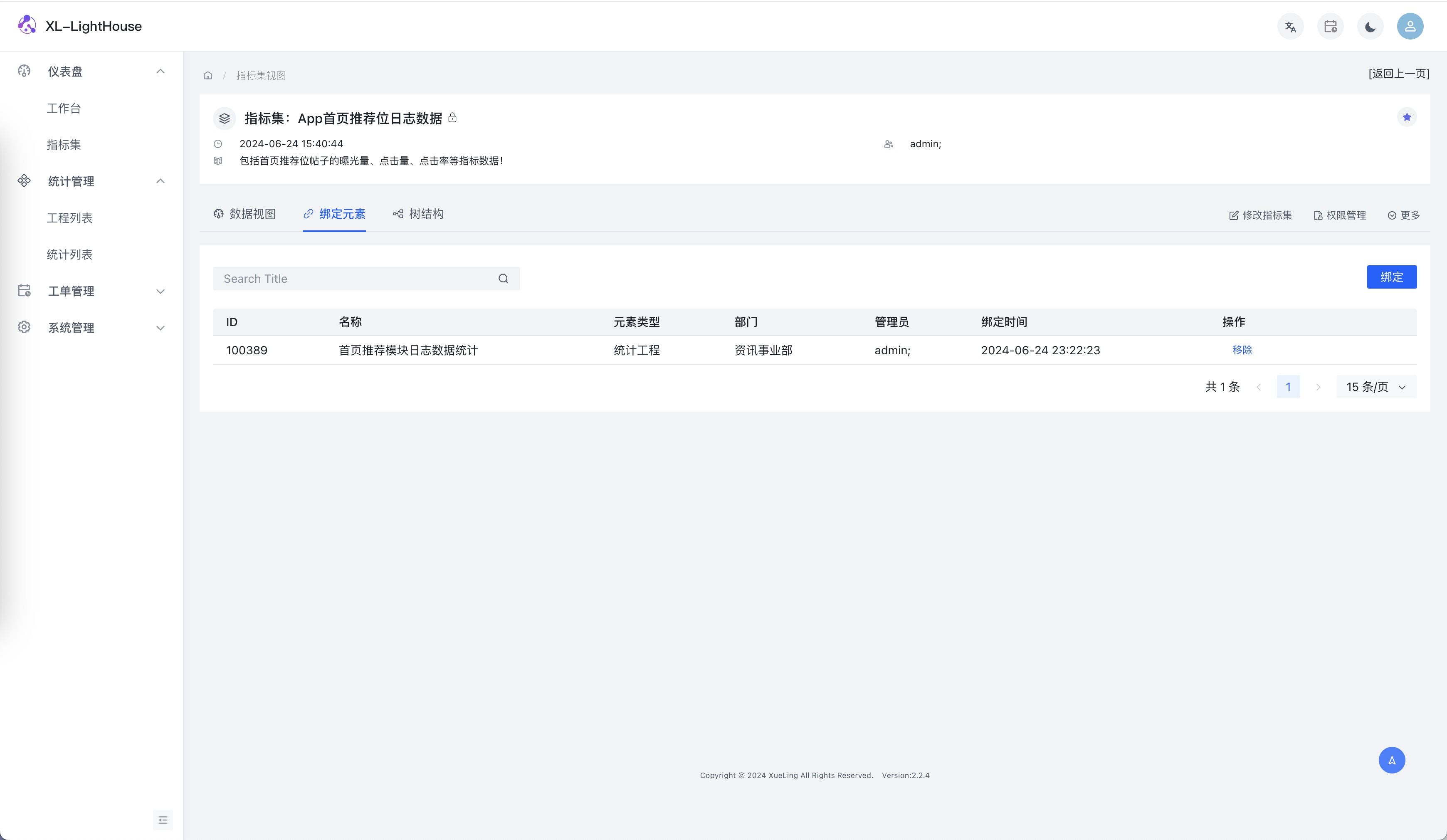

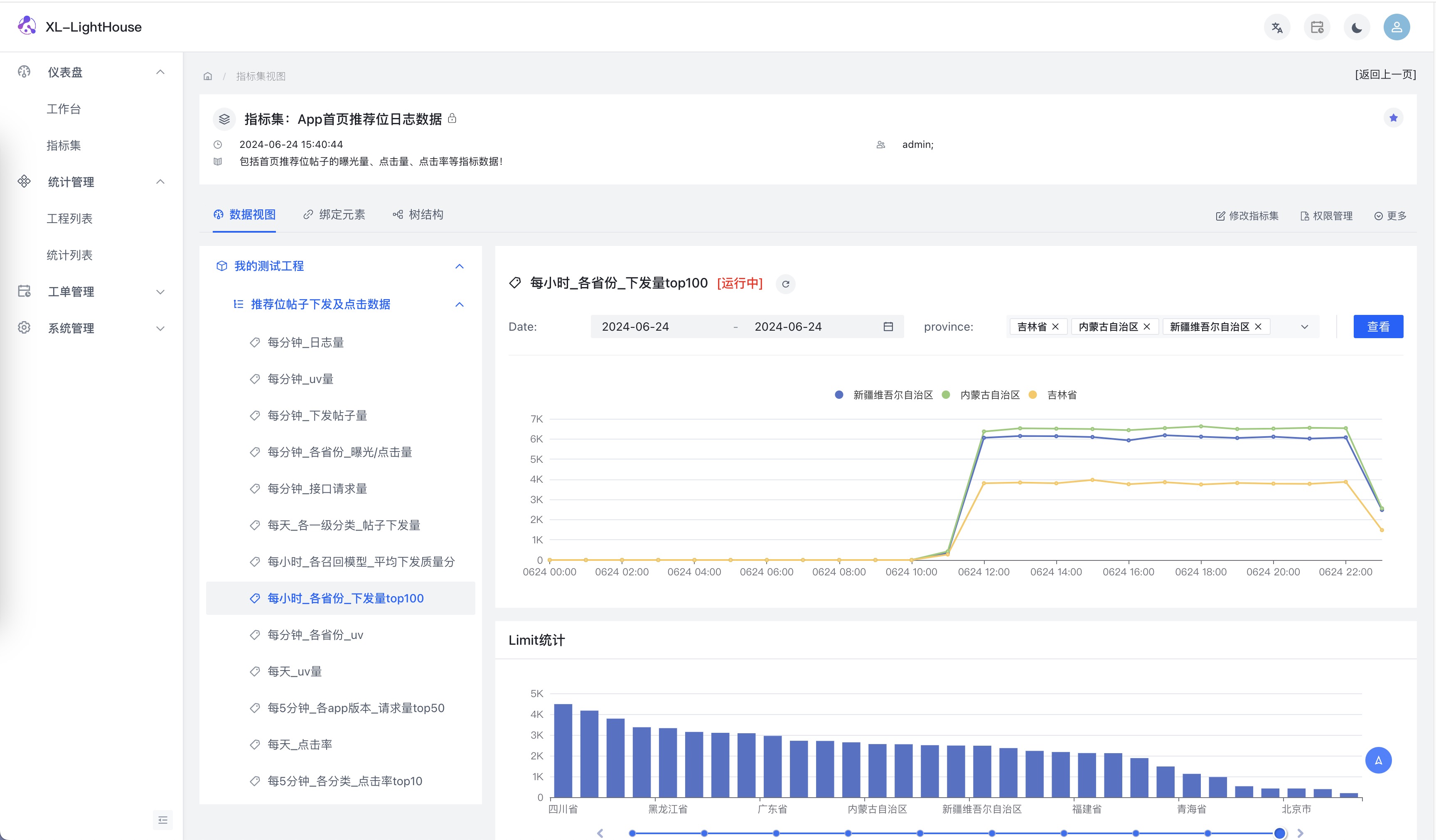

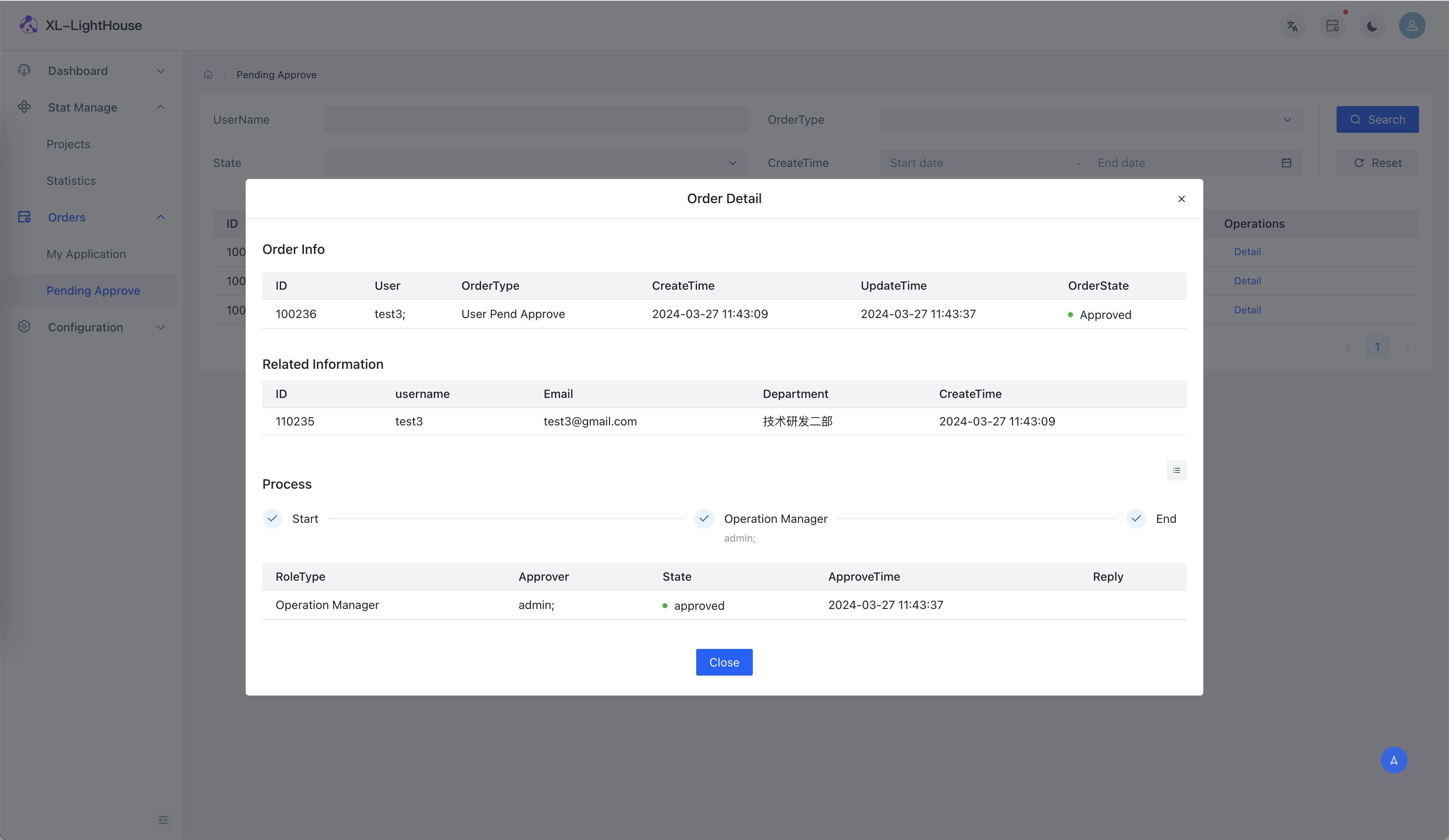

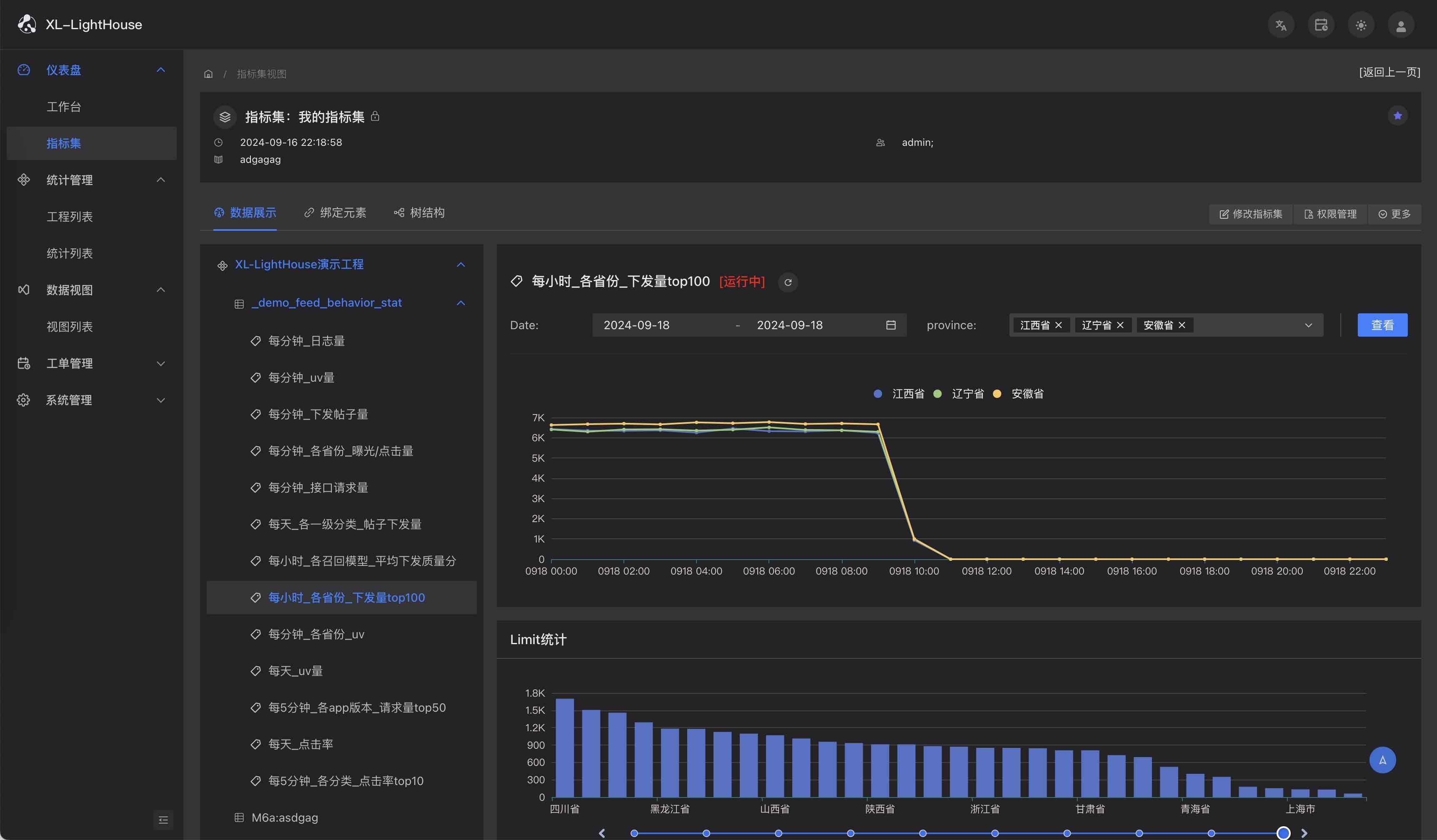

- XL-LightHouse提供了完善的可视化查询功能,对外提供API查询接口,此外还包括数据指标管理、权限管理、统计限流等多种功能。

- XL-LightHouse支持时序性数据的存储和查询。

项目特点

- 并行承载1000万个数据指标,每天高效处理5000亿条消息,基于通用型流式数据统计技术实现,依据流式统计的运算特点而设计,并对每一种运算单元进行反复优化,使得每一种运算单元可以以非常低的成本,无限制复用;

- 可以短时间内快速实现庞大量级数据指标,而这是Flink、Spark、ClickHouse、Doris、Prometheus、时序数据库等之类技术所远远不能比拟的,可以支撑支撑百万量级数据指标,低成本触达每一个细微的产品模块,帮助企业搭建遍布全身的数据化运营体系;

- 对单个流式统计场景的数据量无限制,可以非常庞大,也可以非常稀少,既可以使用它完成十亿级用户量APP的DAU统计、几十万台服务器的运维监控、一线互联网大厂数据量级的日志统计、一线电商企业的订单统计、全世界最大的社交类产品的消息量统计、也可以用它统计一天只有零星几次的接口调用量、耗时状况。XL-LightHouse拥有强大的实时计算能力,可以承载上述所有业务场景,并且一套XL-LightHouse服务,可以同时承载上述所有业务场景;

- 与同领域其他技术方案不同,XL-Lighthouse擅长应对“繁杂”的数据统计需求,企业规模越大、业务场景越多、数据指标需求越多,XL-LightHouse的优势就越明显;

- 有完善的API,支持高并发查询统计结果;

- 支持数据自动备份、可以一键导入历史数据、可以方便的执行集群扩容/缩容;

- 前端基于最新版ArcoDesign(React版本)开发,页面清爽大气,操作体验非常好;

- 所有代码100%开源,方便进行二次开发;

- 轻量级开箱即用,一键部署、系统运维和数据接入完全不需要大数据相关经验,普通工程人员即可轻松驾驭;

可以用来做什么?

XL-LightHouse可应用在企业生产的众多环节,面向企业至上而下所有职能人员共同使用,以电商企业来说:

- 可以为企业决策层提供其所关注的平台交易额、交易量、下单用户数、订单平均金额、人均消费金额等指标;

- 可以为产品经理提供其所负责产品模块的pv、uv和点击率等指标,只要您有业务需要,xl-lighthouse可以为您计算app内每一个按钮、表单、列表、icon、搜索框等的用户行为统计指标;

- 可以为运营人员提供关注的拉新用户量、各访问渠道用户量、站内各个广告位的点击量、点击用户数、点击收益等指标;

- 可以为开发人员提供其关注的接口调用量、异常量、耗时情况等指标,可以辅助进行压力测试;

- 可以为算法工程师提供其关注的模型训练时长、模型上线后的效果评测等指标,可以辅助进行ABTest;

- 可以为运维人员提供其关注的是线上集群的CPU、内存、负载状况、IO、请求数、流量传输大小等监控指标;

- 可以为UI设计师提供其关注的不同设计方案的点击转化对比情况;

- 可以为数据分析师提供全面的数据指标更准确判断业务短板、业务走势、辅助决策层有针对性制定营销计划;

- 可以为销售主管提供其关注的每个下属的营销电话量、营销平均通话时长等指标;

- 可以为HRBP提供其关注的各个部门每个员工每天的打卡情况、工作时长等指标;

- 可以轻松实现对各类复杂业务逻辑各主要环节的数据监控,及时发现问题并辅助问题排查。

- 可以快速建立数据指标之间的交叉验证体系,轻松佐证数据指标的准确性。

针对不同业务领域实现相应的指标需求:

- 可以面向物联网、工业互联网、车联网、智能制造、现代农业、智能工厂、智能交通、智能电厂、智能家居、机器人、无人机等众多场景实现各类科技设备相关数据指标统计和运行状态监控;

- 短视频App关注的某个视频的播放量、点赞量、主播关注量、评论量、完播率,每天每个主播的新增关注量、取关量,直播间的访客量、停留时长、刷礼物的数量、打赏金额;

- 即时通信服务所关注的聊天消息量、消息送达时长、日活跃用户,音视频通话相关的丢包率、网络延迟情况;

- 游戏领域所关注的登录用户数、游戏对局次数、英雄出场次数、游戏对局时间、游戏丢帧率、网络延迟情况、技能释放次数、英雄胜率;

- 房产类App关注的各个城市各个片区每天房源上架量、下架量、涨价量、降价量;

- 交通领域关注的各城市的各条道路的车流量、人流量;

- 建筑领域关注的各城市的每栋建筑的承压健康情况;

- 水利领域关注的每条河流每条河段的水温、水质、水位、水流速度等情况;

更多场景可参考:

单机版本

XL-LightHouse除了大数据版本外,同时支持单机版。单机模式成本低廉,最低配置只需要一台4核8G的云服务器。

适用场景:

- 面向中小企业或中小型业务团队使用;

- 面向"用完即弃"的使用场景;

有些时候对数据指标的需求,往往只在某个特定阶段。比如:新接口上线要进行接口的压力测试、性能优化;线上业务出现数据异常问题需要排查;数据库读写压力突然暴涨,需要确定异常请求的来源等等, 对于此类场景,流式统计可以起到至关重要的作用。但这类场景一般不需要持续很长时间,可能两三周甚至两三天。这种情况可以使用单机版本。一键部署,轻量级使用,问题排查完,将XL-LightHouse删除即可,灵活的使用XL-LightHouse可以为您解决很多棘手的问题!

- 用于初步体验XL-LightHouse或作为二次开发的联调测试环境;

日常运维

快速上手

XL-LightHouse介绍

项目地址

- Github:https://github.com/xl-xueling/xl-lighthouse

- Gitee:https://gitee.com/xl-xueling/xl-lighthouse

- 文档地址:https://dtstep.com/

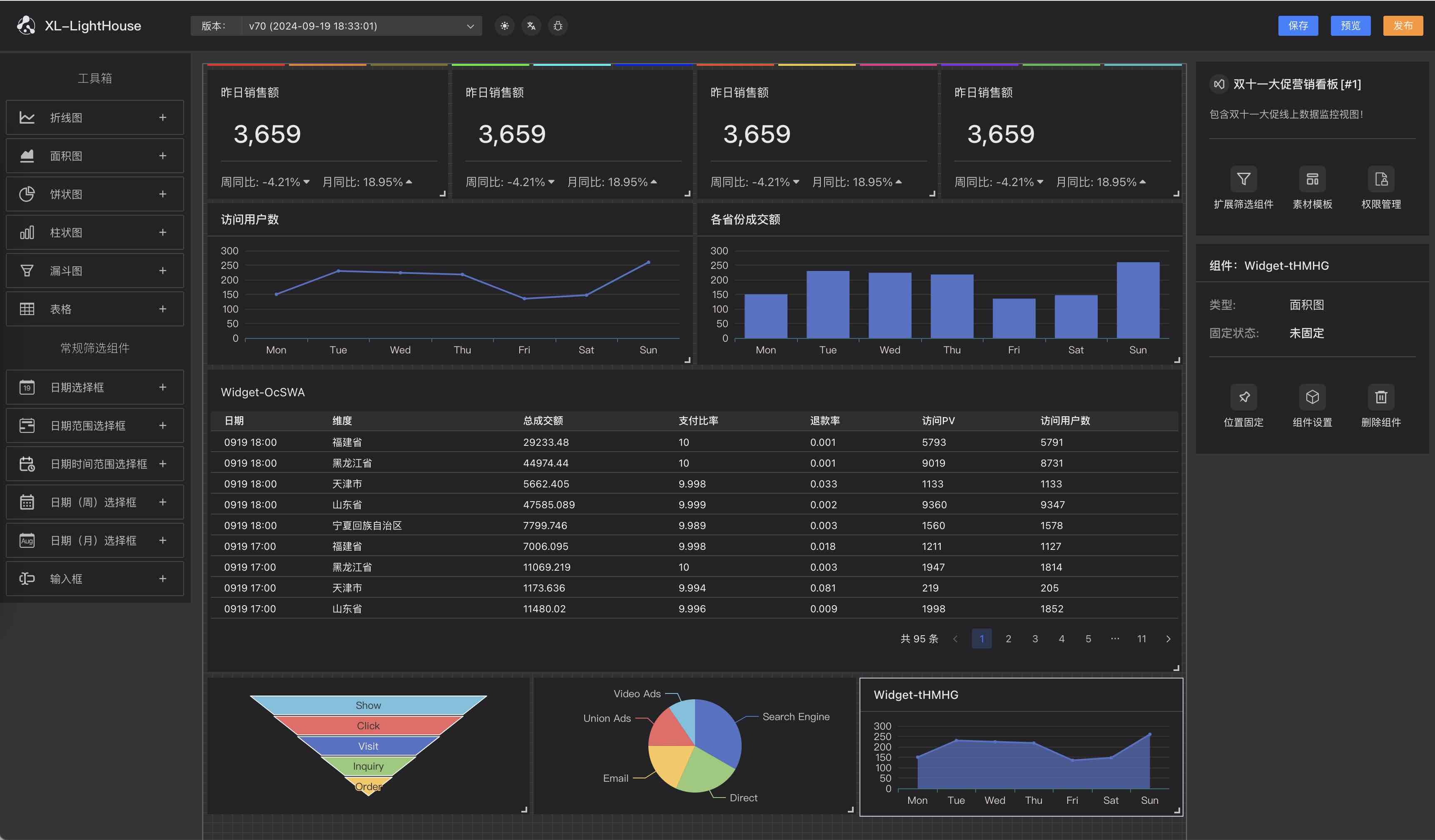

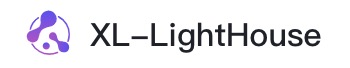

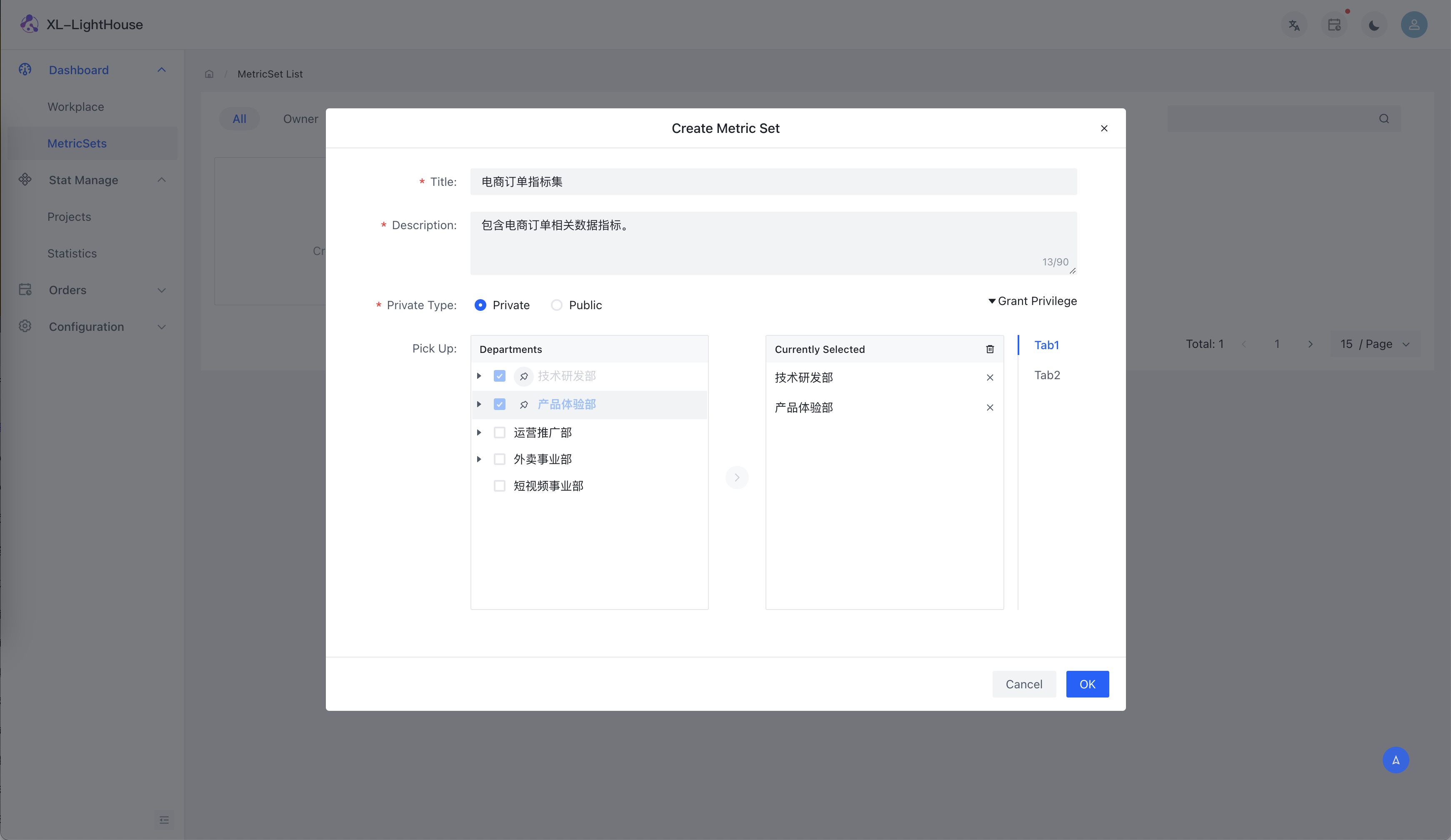

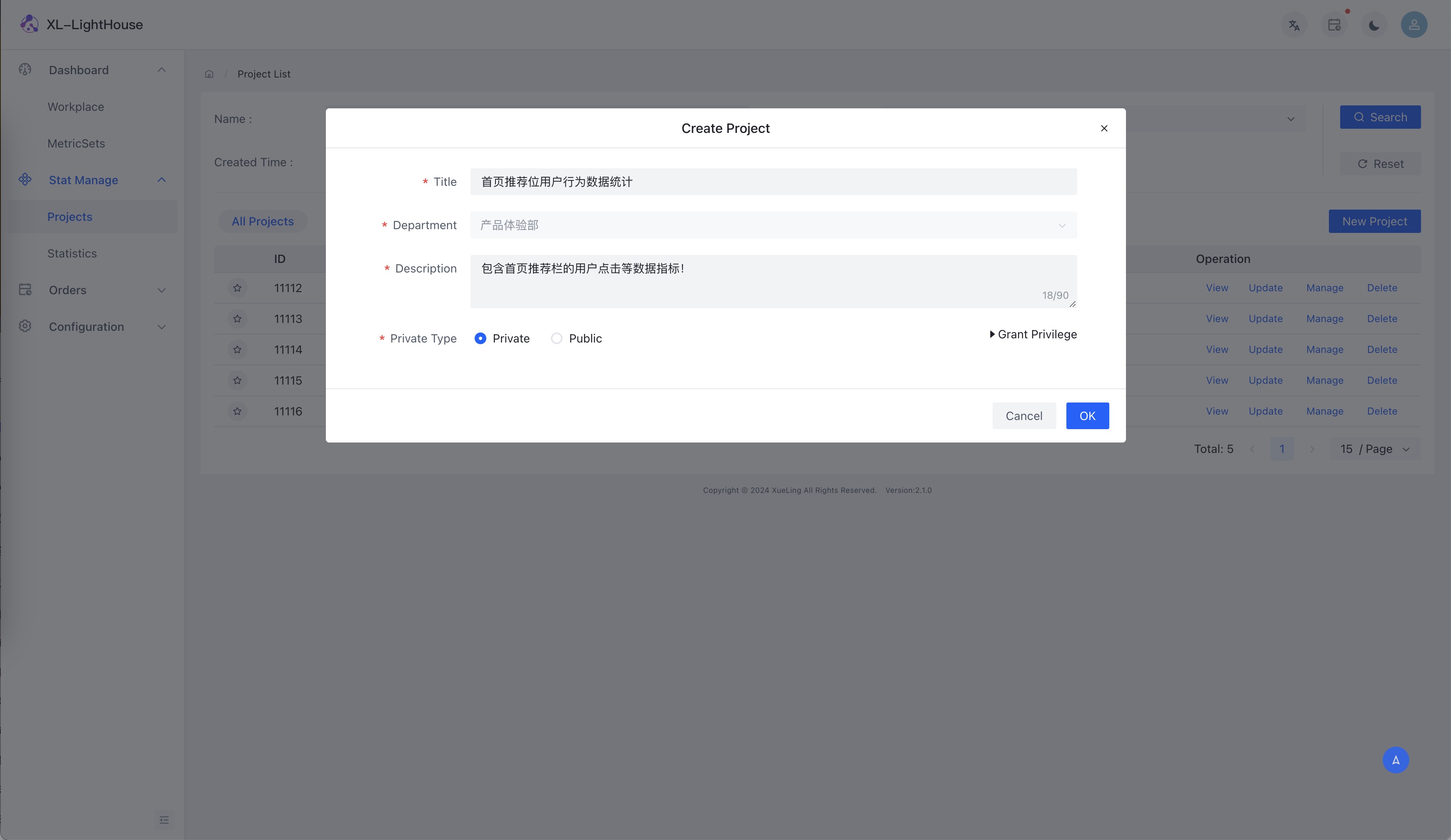

开源版本Web端部分功能预览

商业版本是在开源版本的基础上额外新增功能,开源版本所有已提供的功能不会有任何使用层面的限制(比如不会限制数据量、集群规模、统计指标数量、Web系统访问人数等等)。

商业版本Web端部分功能预览